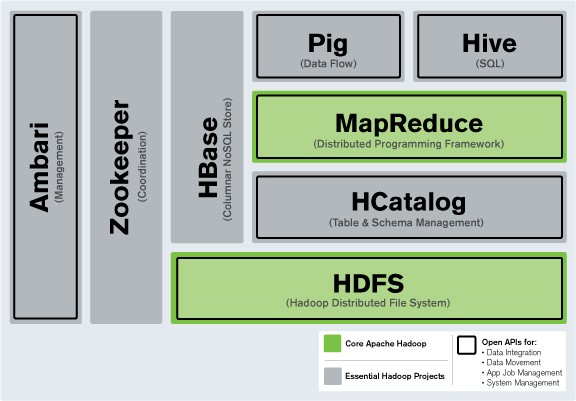

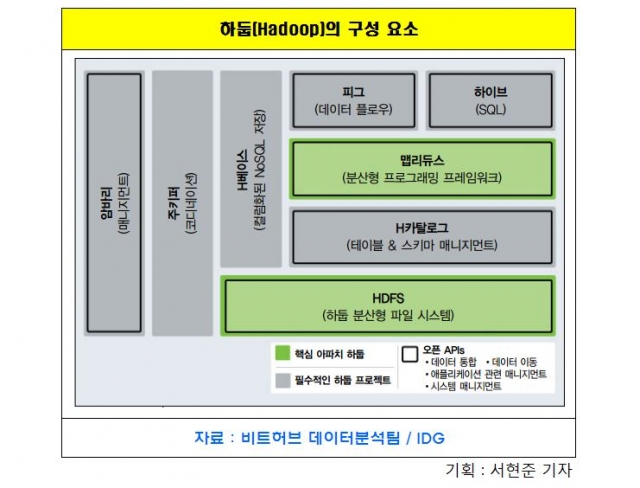

Haddop이란?Haddop은 대규모 데이터 세트를 분산 처리하는 프레임워크로 빅데이터 저장과 분석을 위한 분산 컴퓨팅 솔루션입니다. Java 소프트웨어 프레임워크이기 때문에 Hadoop을 이용하려면 Java를 선행적으로 설치해야 합니다.

보통 Hadoop을 설치하기에는 복잡하고 또 요즘에는 Docker로 구성되어 있는데 저처럼 빅데이터를 공부하는 학생이나 컴퓨터 공학부 학생이라면 VMware를 이용하여 가상 환경에서 특히 Linux Ubuntu와 같은 환경에서 설치해야 하는 경우가 있습니다. 나도 이러한 이유로 Hadoop을 설치하게 되었고, 설치 과정에서 오랜 시간과 힘든 일이 많았기 때문에 나와 같은 상황을 막기 위해 해당 포스팅을 작성하게 되었습니다.

1. 선행 작업 Hadoop을 설치하기 위해 포스팅을 방문하신 분이라면 아마 VMware와 Linux 환경은 구성되어 있을 것 같아서 시작합니다.1)apt업데이트

sudo apt_get 업데이트

2)자바 8을 설치합니다.

sudo apt-get install openjdk-8-jdk open-8-jre

3)인스톨 확인 부탁드립니다.

자바 버전

2. SSH설정1) Opensh Server 설치

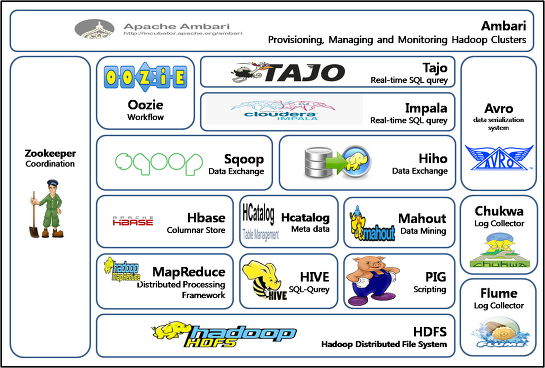

sudo apt-get install opensh-presiduadopt-get install pdsh2)SSH 키를 만듭니다.$ssh-keygen-t rsa-P”-f~/. ssh/id_rsa#키성생 공개/개인rsa키페어를 생성하고 있습니다.ID는/Users/centos/. ssh/id_rsa에 저장되어 있습니다.공개 키가/Users/centos/. ssh/id_rsa.pub에 저장되었습니다.주요 지문은 다음과 같습니다:SHA256:abcdefghijklmnopqrstuvwxyz1234567890 centos@hostname키의 랜덤 아트 화상:+—[RSA 2048]——–+|···||. . .||. o.|.+o=||S.*=+||. o+.. . ./——————-.+|=+||/+.E|| oo .||. o.||.+-[SHA256]——+3)SSH 패스워드를 해제합니다.cat ~.module/id_module.pub >> ~.module/authorized_keysSSH 인증을 위한 RSA 키 쌍을 생성하는 데 사용되는 명령어입니다. 매번 ssh에 접속할 때 비밀번호를 입력하면 번거롭기 때문에 이 명령을 실행하면 비밀번호 없이 RSA 키쌍(공개 및 개인키)이 생성되고 id_rsa 파일에 개인키가 저장되며 id_rsa.pub 파일에 공개키가 저장됩니다. 그러나 보안이 중요한 경우 암호를 사용하여 개인 키를 적절하게 보호하는 것이 좋습니다.4)키를 포함한 파일의 권한을 변경 및 확인합니다.cat ~.message/id_message.pub >> ~.message/authorized_keys #titlesch localhost #debughtml3. Hadoop 설치1) Hadoop 다운로드 https://hadoop.apache.org/Apache Hadoop Apache Hadoop 프로젝트는 신뢰성과 확장성이 뛰어난 분산 컴퓨팅을 위한 오픈 소스 소프트웨어를 개발하고 있습니다. Apache Hadoop 소프트웨어 라이브러리는 단순한 프로그래밍 모델을 사용하여 대규모 데이터 세트를 컴퓨터 클러스터 전체에 분산 처리할 수 있는 프레임워크입니다. 그건… hadoop.apache.org사이트에 가서 최신 버전을 다운받으셔도 됩니다. 현재 최신 버전은 3.3.6입니다. 다만 자바와 호환되지 않는 버전도 있을 수 있으니 참고해주세요. 저는 3.1.3버전으로 다운받았습니다.wget https://archive.apache.org/dist/hadoop/common/hadoop-3.1.3/hadoop-3.1.3.tar.gz2) 압축 해제합니다tar-xzvf hadoop-3.1.3.tar.gz3) 디렉토리 이동mv hadoop-3.1.3 /home/user1/hadoop이렇게 하면/home/본인의 계정 이름/hadoop의 위치로 이동합니다.나중에 이 패스는 Hadoop의 환경 변수 설정이나 관련 파일의 수정에 필요한 패스입니다.4. 하도우프 설정 하도우프은 크게 4가지로 구성되어 있습니다Hadoop Common-Hadoop의 다른 모듈을 지원하기 위한 공통 성분 모듈 Hadoop HDFS-분산 보존을 처리하기 위한 모듈.복수의 서버를 1개의 서버처럼 묶어 데이터를 저장합니다.Hadoop YARN-병렬 처리를 위한 클러스터 자원 관리 및 스케줄링 담당 Hadoop MapReduce-분산하여 저장된 데이터를 병렬 처리할 수 있도록 하는 분산 처리 모듈. 그래서 Hadoop설정은 해당 4개의 모듈을 설정하는 것으로 보여집니다.각 모듈의 파일을 수정하면서 다른 필요한 모듈을 추가하는 등의 설정이 가능합니다.1)환경 변수의 설정입니다~~/bashrc 땀을 흘리다.먼저 환경변수 설정창에 들어갑니다. (nano 에디터가 아닌 vi 에디터를 사용하셔도 됩니다.) 진입 후 아래와 같은 코드를 작성합니다.변환, HADOOP_HOME=”/home/user1/hadoop”#엑스포트, PATH=$PATH:$HADOOP_HOME/binexport PATH=$PATH:$HADOOP_MAPRED_HOME=${HADOOP_HOME}export HADOOD_COMMON_HOME=${HADOOP}EXPORT HADDOOM_HDOME=$HADOWFS}export HADMOME{$HOOM_HOME}EXPORE_HDO2) 설정한 환경변수를 적용합니다.소스~.bashrc3) env.sh 수정 하둡 관련 파일을 수정할 때는 앞서 말씀드린 것처럼 /home/user1/hadoop/etc/hadoop으로 이동하여 수정해야 합니다. env.sh 파일에 앞서 다운로드한 jdk 경로를 입력하여 저장합니다.cd /home/user1/hadoop/etc/hadoopsudo nano hadoop-env.shexport JAVA_ をエクスポートするHOME=/usr/lib/jvm/java-8-openjdk-amd644)core-site.xml 수정합니다.sudo nano core-site.xml <設定><コマンド><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property><name>hadoop.tmp.dir </name><value>/home/user1/hadoop_tmp </value></property></configuration>5)hdfs-site.xml 수정합니다.sudo nano hdfs-site.xml <設定><value><name>module.authentication</name><value>1</value><value>module.secondary.authentication.address</name>module>module:50090</value></configuration>6)mapred-site.xml 세부 사항sudo nano map red-site.xml<설정><value><name>mapreduce.framework.name</name><value><value></value><value><title><name>yarn.app.mapreduce.am . env</name><value><value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value></property><name>mapreduce.map.env</name><value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value></property><name>mapreduce.reduce.env</name><value>HADOOP_MAPRED_HOME=$HADOOP_HOME</value></property></configuration>7)yarn-site.xml 수정합니다.sudo nano yarn-site.xml <設定><flash><name>mapreduce.mapmanager.aux-services</name><value>mapreduce_protocol</value><flash>mapreduceduce.aux-services.マップリデュースを使用します。shuffle.class</na><value>html.html。hadoop.mapred を指定します。ShuffleHandler</value></property></configuration>8)적용됩니다cdsource ~/.cdrc4. Hadoop실행1) namenode 포맷입니다.cd/lib/user1/hadoop/binhdfs 이름 노드 – @ info2)실행cd /etc/user1/hadoop/sbinstart-dfs。shstart-yarn.shstart-dfs.sh 입력시 아래와 같은 permission denid가 발생한 경우아래와 같은 명령어를 입력하고 다시 start-dfs.sh 를 실행하십시오.에코 “ssh” sudo south tee/south tee/south/pdsh/rcmd_default3)확인 jps 명령어를 입력하면 아래와 같이 프로세스 6개가 동작 중이면 Hadoop 설치 완료입니다.jpsjps생각보다 설치 방법이 굉장히 다양하고 또 저는 여러 개의 컴퓨터를 사용하는 것이 아니라 하나의 컴퓨터를 사용해서 하둡 사용법을 익히는 것이 목표이기 때문에 적절한 방법을 찾는데 시간이 걸렸습니다. 이 포스팅을 보신 분은 삽을 사용하지 마시고 설치해 주세요!